Hubo un tiempo en que internet era la promesa de un mundo libre. Pero llegó un día en que empezamos a pensar que necesitábamos la censura.

La mayoría de plataformas, redes sociales, foros, chats o juegos online nacieron sin límites. Entre sus paredes virtuales podías hacer, más o menos, lo que quisieras. Pero para no acabar convirtiendo la red en un universo de violencia, pornografía y actividades delictivas, pronto se empezaron a establecer filtros. Normas de comportamiento.

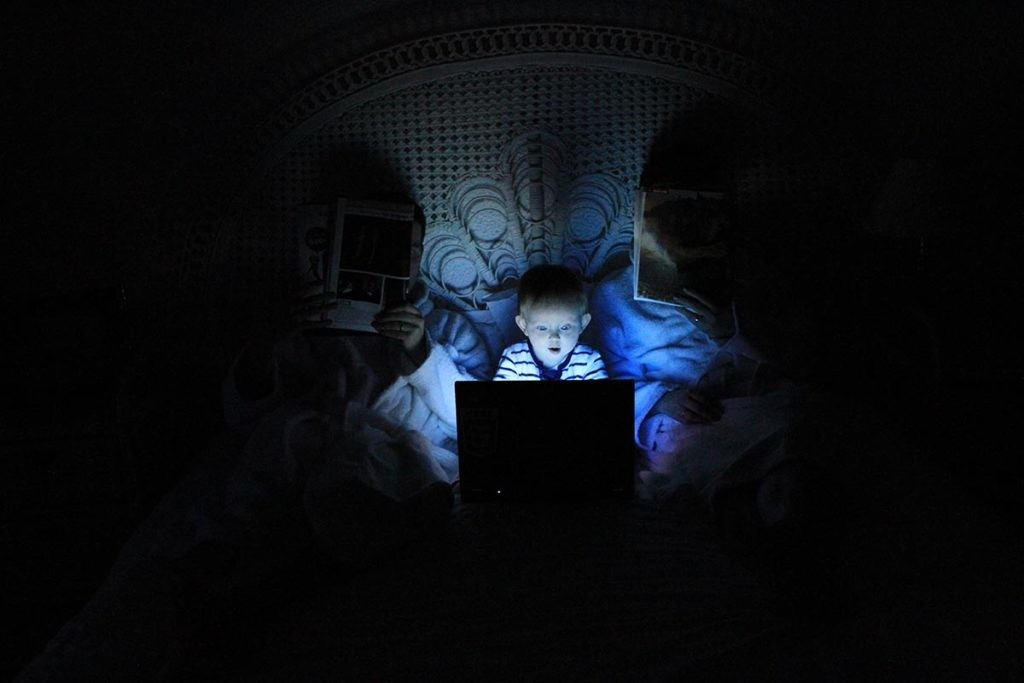

En los últimos años, ante el auge de los discursos de odio y, también, el temor a la poscensura, estos filtros se han reforzado. Hoy, la mayoría del contenido es revisado de forma automática por una inteligencia artificial. Cada plataforma tiene la suya. Pero, casi siempre, las decisiones de esta IA tienen que ser confirmadas y refinadas por un par de ojos humanos. Una persona que lee, escucha y ve todo lo que el resto del mundo no quiere ver. Son los escudos humanos de internet.

Moderador de contenidos: ¿quién es quién?

Una búsqueda rápida en LinkedIn arroja cerca de 400.000 personas trabajando en el campo de la moderación de contenidos. Y no es demasiado suponer que existan muchos moderadores que no están en esta red social. El filtrado de vídeos, fotos y mensajes se ha convertido en un gran negocio en el que conviven consultoras y empresas más pequeñas con corporaciones que acaparan los contratos con las grandes redes sociales como Facebook, YouTube o Twitter. Además, muchas plataformas online cuentan con sus propios moderadores en plantilla.

“El trabajo de los moderadores de contenido ha sido visto de forma negativa en el pasado. Sin embargo, moderar contenido inapropiado online es un trabajo vital que debe hacerse para proteger a los usuarios inocentes […]”. Así define el trabajo TaskUs, una consultora digital que modera contenido, entre otras tareas, para empresas como Mailchimp, Eventbrite o Hootsuite. Un trabajo que es especialmente difícil en la esfera de las redes sociales.

Facebook es, ante todo, grandes cantidades de información. Cada minuto, se publican más de 500.000 comentarios y cerca de 150.000 fotos en la mayor red social del planeta. En ella conviven 2.400 millones de personas. Para la titánica tarea de revisar (y, quizá, censurar) todo ese contenido en tiempo real cuenta con el ejército de Cognizant. Una gran parte de sus casi 300.000 empleados en todo el mundo controla que todo lo que se publica en Facebook cumpla con sus normas.

Cognizant ha recibido mucha atención en los últimos meses. Reportajes como este de ‘The Verge’ profundizan en las condiciones en las que trabajan los moderadores de internet. Pero Cognizant no es la única. Lionbrigde, LiveWorld o consultoras clásicas como Accenture juegan su papel para impedir que el contenido traumático llegue a la mayoría de los usuarios. Pero ¿cómo lo viven los propios moderadores?

Estos son los testimonios de tres de ellos. Sus identidades están protegidas porque su trabajo está sujeto a una estricta política de confidencialidad y para no dañar a la empresa de la que son o eran empleados.

En la trinchera de internet

“Durante la entrevista [de casi dos horas] me mostraron imágenes de todo tipo. Sexuales, violaciones, matanzas, decapitaciones, bombas, atentados, insultos… Querían ver cómo reaccionaba a ellas y cómo actuaría si las recibiese”. Por este y otros motivos, Mario A. decidió no continuar con el proceso de selección para un puesto de trabajo de moderador de contenido en Cognizant el pasado mes de mayo.

“Fueron muy insistentes preguntándome si me veía capaz de soportarlo. Que a mucha gente le costaba porque era bastante duro”, continúa. “Estamos acostumbrados a ver contenido sensible en internet. Pero lo hacemos de forma esporádica. Este trabajo sería estar consumiendo ese tipo de contenido siete horas al día cinco días a la semana. Y estás obligado a escucharlo con audio, con los gritos y los llantos, lo que lo hace aún más duro”.

Facebook es la red social que más presión pública recibe para controlar el contenido. Las acusaciones de no hacer suficiente para frenar los discursos de odio (algunas tan duras como la efectuada por la ONU en relación al genocidio de los rohinyá en Myanmar) han hecho mella en la compañía. Desde 2017, la red social ha aumentado su equipo para moderar el contenido antes de su publicación. En la actualidad trabajan en ello más de 30.000 personas entre empleados de Facebook y de terceras compañías, entre las que destaca Cognizant.

El proceso empieza con una queja de un usuario o un post señalado por un algoritmo de inteligencia artificial. Automáticamente pasa a ser revisado por un moderador. Sea el contenido que sea, siempre es una persona la que toma la decisión final. Lo hace en base a un conjunto de reglas que Facebook actualiza constantemente en busca del equilibrio (si acaso es posible) entre libertad de expresión y censura objetiva.

Hoy por hoy, esas normas son muy detalladas (y parcialmente públicas). Buscan erradicar la violencia, reforzar la seguridad de las personas y comunidades y proteger la propiedad intelectual. Además, señalan gran cantidad de contenido inaceptable que debe ser siempre bloqueado. Estas normas se amplían y se revisan con regularidad. De hecho, su estudio forma parte de la jornada de trabajo habitual de los moderadores de contenido. Una realidad que se repite no solo en Facebook.

“Comienzo mi jornada laboral abriendo material de apoyo para facilitar nuestra tarea como correos, material teórico con información sobre cada política específica dividida por tipo de contenido o bases de datos”, explica Rubén M. analista de contenido para una popular plataforma de vídeo online. “Una vez hecho esto, analizo y modero los vídeos almacenados en la queue de español teniendo en cuenta el target programado para el día o la semana de trabajo”.

Tiene, aproximadamente, 20 minutos para estudiar el caso concreto de cada vídeo. La mayoría de sus vetos van destinados a frenar discursos de odio, contenido violento y vídeos sexuales y de menores. Se pasa ocho horas al día (descansos aparte) haciéndolo. Asegura que no le afecta en especial, que lo lleva bien. Aun así, explica que la empresa para la que trabaja pone a su disposición un psicólogo en caso de necesidad.

“El mayor desafío al que uno se enfrenta para moderar contenidos de este tipo es tratar de no caer en juicios personales o, más bien, de evitar basar nuestras decisiones en valoraciones subjetivas. Nos ocupamos de temas delicados que requieren de una visión totalmente imparcial y neutra”, añade Rubén M. De nuevo, la censura objetiva y neutra. Un concepto cada vez más habitual que habría rechinado en los albores de internet.

La difícil tarea de vigilar la red de redes

Hay casos en los que muchos usuarios parecen entender la censura. ¿Por qué tenemos que ver un vídeo de una decapitación? ¿O de una violación? Sin embargo, también hay quien defiende que, sea como sea, la libertad de expresión debe prevalecer por encima de todo. Casos como los que señala Juan Soto Ivars en su ‘Arden las redes’ bucean, precisamente, en esas zonas grises de la poscensura.

Pero volvamos a la moderación de contenido. Sin entrar en debates éticos, las plataformas buscan cubrirse las espaldas, sobre todo, ante comportamientos delictivos. En el año 2012, una investigación del canal británico Channel 4 reveló que un juego online de tipo vida virtual estaba siendo utilizado para distribuir pornografía infantil. Ellos no lo sabían. A partir de ahí, no pasó ni un solo minuto más sin que el juego estuviese vigilado.

“Cada moderador tenía acceso a toda la conversación que estaba teniendo lugar en la sala. Todo lo que pasa en la sala se podía moderar, incluido los mensajes privados”. José D. formó parte de ese equipo hasta hace cuatro años. “Veíamos de todo. Desde cibersexo, que iba desde comentarios infantiles hasta cosas de adultos, hasta tendencias suicidas”.

“Una vez, un usuario empezó a decir cosas muy deprimentes, que se sentía solo, que se iba a beber una botella de vodka, que tenía un cuchillo y no sabía qué iba a hacer… Teníamos la responsabilidad de poder parar algo que podría ser muy importante. Fue bastante duro. Estuve revisando su chat y era todo así. Le di autenticidad y lo reporté”, explica José D. “Me lo llevé a casa. Durante bastante tiempo estuve pensando qué habría pasado. Nunca supe nada más”.

En este caso, el problema no era solo consumir el contenido, sino implicarse. Y es que los moderadores estaban en contacto constante con los usuarios de la plataforma. “Un problema que sí que teníamos era que los moderadores recibíamos mensajes de acoso. Algunos usuarios se enteraron de mi nombre real y me enviaban mensajes a mi dirección personal. Hubo un compañero que controlaba las salas de América Latina al que le crearon un perfil falso en Twitter con una foto suya y su nombre en el que le llamaban pedófilo”, añade este ex moderador de contenido.

Prohibir contenido pedófilo o frenar un suicidio. Son acciones fácilmente comprensibles. Pero cuando se censura una foto en la que parece que se muestra un pezón o un post de opinión que puede ocultar (o no) información falsa, la cosa se complica. Y ya si analizamos la moderación de contenidos en países donde no están garantizadas las libertades individuales, el tema se vuelve insostenible.

Hace ahora un año, el Alto Comisionado de las Naciones Unidas para los Derechos Humanos pidió formalmente a los gobiernos y a las empresas de internet que protegiesen el derecho a la libertad de expresión por encima de todo. Al fin y al cabo, la censura se sabe donde empieza, pero nunca donde acaba.

¿Es posible expresarse libremente y no herir sentimientos al mismo tiempo? Mark Zuckerberg y los suyos aseguran que sí. Muchos expertos creen que es imposible. El debate sigue abierto. Los escudos humanos de internet siguen vigilando.

En Nobbot | “En la batalla contra la mentira no podemos permanecer como espectadores“

Imágenes | Unsplash/Jeremy Bishop, Edi Libedinsky, Ludovic Toinel, Su San Lee