El investigador del CSIC y profesor de la Universidad de Sevilla José M. de la Rosa firma De la micro a la nanoelectrónica, el último título de la colección «¿Qué sabemos de?» (CSIC-Catarata). En sus páginas, el autor hace un recorrido por los principios y componentes esenciales de la microelectrónica.

El investigador del CSIC y profesor de la Universidad de Sevilla José M. de la Rosa firma De la micro a la nanoelectrónica, el último título de la colección «¿Qué sabemos de?» (CSIC-Catarata). En sus páginas, el autor hace un recorrido por los principios y componentes esenciales de la microelectrónica.

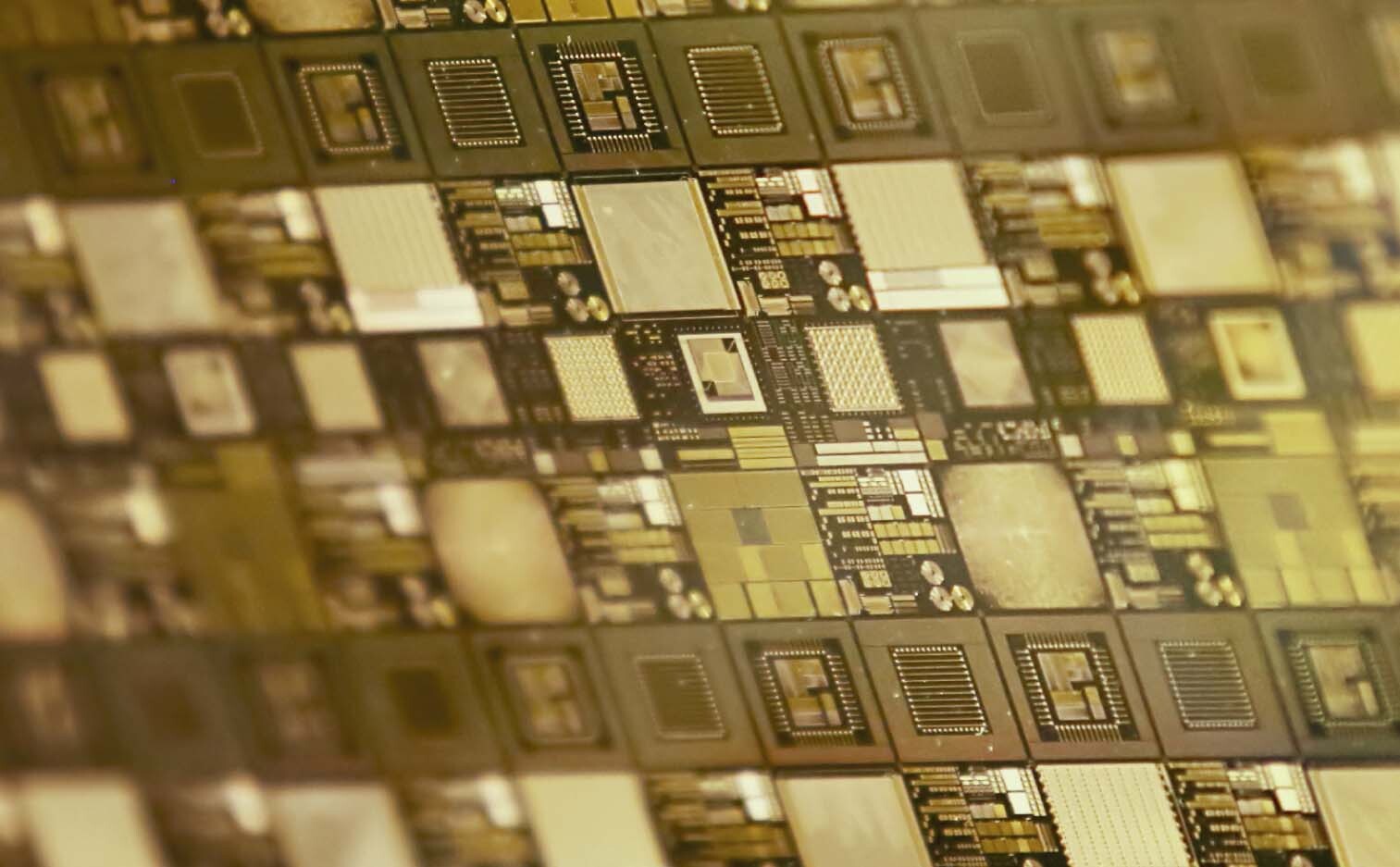

Hoy en día se pueden construir chips que contienen en su interior miles de millones de componentes de dimensiones cercanas al nanómetro. Ello hace posible aplicaciones que hubieran sido consideradas ciencia ficción hace tan solo una década. La computación neuronal, los ordenadores cuánticos, la radio cognitiva o los circuitos integrados en sustratos flexibles son algunos ejemplos. A pesar de estas ventajas, el diseño de la microelectrónica conlleva afrontar un gran número de retos científicos para seguir beneficiándonos del escalado tecnológico más allá de la ley de Moore.

En este libro se presenta un recorrido panorámico de la micro a la nanoelectrónica, con el fin de ofrecer una visión global y didáctica, que abarca el presente-futuro de esta tecnología, impulsora de la transformación hacia la sociedad digital en la que nos hallamos inmersos.

los inicios de la microelectrónica

En 1947 los investigadores Walter Brattain, John Bardeen y William Schockley, de los Laboratorios Bell de AT&T, inventaron el primer dispositivo electrónico basado en semiconductores capaz de amplificar señales eléctricas. Se denominó transistor y fue mejorándose hasta que, a mediados de la década de los cincuenta, comenzó a utilizarse para fabricar receptores de radio mucho más compactos y portátiles que los existentes hasta el momento, y más tarde reemplazó a otros dispositivos electrónicos. Apenas una década después, en 1958, Jack Kilby, un joven físico e ingeniero contratado por la compañía Texas Instruments, tuvo la idea de fabricar todos los elementos necesarios para realizar un circuito —resistores, condensadores, inductores y transistores— empleando materiales semiconductores e integrándolos en un sustrato común. El resultado fue lo que hoy denominamos circuito integrado.

Así fue como sucedió el nacimiento de la electrónica moderna, la microelectrónica. Desde entonces, se han fabricado dispositivos cada vez más compactos, capaces de hacer posible en la actualidad aplicaciones tan punteras como la computación neuronal o los ordenadores cuánticos. Esta evolución no ha cesado y, lejos de estar agotada, nos lleva hacia la transformación digital en la que nos hallamos inmersos.

“Se está produciendo un fenómeno paradójico: la ciudadanía desconoce qué es un chip o cómo se diseña o se fabrica, pero hace un uso exhaustivo de ellos”, comenta el investigador del Instituto de Microelectrónica de Sevilla. En este escenario, “el libro pretende ofrecer los conocimientos básicos para comprender una tecnología que hace posible muchos de los descubrimientos que utilizamos en nuestro día a día”, añade. Entre otros, los móviles, los ordenadores, los coches o la mayoría de electrodomésticos son ejemplos de que nos relacionamos con la microelectrónica casi en cada momento.

Escalado tecnológico

Una de las claves para su avance constante es la denominada Ley de Moore. “En 1965, Gordon E. Moore, cofundador de Fairchild y posteriormente de Intel, observó la evolución que estaban teniendo las tecnologías de fabricación de los entonces recién nacidos circuitos integrados y predijo que la densidad de transistores, es decir, el número de transistores que podrían integrarse en un chip, se doblaría cada dos años”, relata José M. de la Rosa. Esta predicción se ha cumplido hasta la actualidad, e incluso se ha superado, ya que “se ha conseguido doblar la cantidad de transistores integrados por unidad de área de chip cada 18 meses”.

El escalado o reducción del tamaño de los componentes de un chip tiene multitud de beneficios, pero el autor destaca tres: la disminución del coste por componente al necesitar menos materia prima para su fabricación, el aumento de velocidad de operación y la reducción del consumo energético.

Pero, ¿qué es un chip? El investigador dedica buena parte de las páginas del libro a dar respuesta a esta cuestión, así como a explicar su proceso de diseño y fabricación, qué tipos hay y a qué tecnologías ha dado lugar. “Un chip es un circuito electrónico realizado a escala micro/nanométrica que está formado por la interconexión de un conjunto de dispositivos y componentes integrados en un sustrato de material semiconductor”, explica de la Rosa. El número de componentes electrónicos interconectados en un chip puede ser muy elevado dependiendo de su aplicación. Por ejemplo, los últimos microprocesadores que se encuentran en los teléfonos y tablets de última generación llegan a contener del orden de diez mil millones de transistores.

La «era post-silicio»

Para la fabricación de chips se comenzó utilizando germanio, pero el silicio ha sido el material más importante empleado como sustrato en microelectrónica. Entre otras ventajas, el rango de temperaturas en el que puede operar en comparación con el germanio es más del doble (250oC para el silicio y 100oC en el caso del germanio). Además, es el segundo elemento más abundante en la corteza terrestre. Sin ir más lejos, la arena de las playas está principalmente compuesta por pequeños gránulos de sílice.

Sin embargo, ya se habla de la ‘era post-silicio’ como consecuencia del desarrollo de nuevos materiales y dispositivos que continúan aumentando el nivel de integración y, con ello, el escalado tecnológico. Uno de esos materiales es el carbono, en concreto el grafeno y los nanotubos de carbono. Según el científico del CSIC, “el grafeno tiene unas propiedades físicas extraordinarias. Es casi completamente transparente y 200 veces más resistente que el acero, muy flexible y elástico, por eso puede ser un material ideal para la realización de chips en sustratos flexibles para entornos muy diversos como tejidos, espejos, paredes, monitores, entornos de realidad virtual, etc.”.

¿El final de la Ley de Moore?

El autor ve la micro y la nanoelectrónica como elementos clave para el futuro de tecnologías como el big data, la inteligencia artificial o la interconectividad entre personas y objetos, fenómeno conocido como internet de las cosas (IoT por sus siglas en inglés), que están contribuyendo a la transformación digital. El investigador del Instituto de Microelectrónica afirma que nos encaminamos hacia un nuevo paradigma de computación donde la comunidad científica trabaja, por ejemplo, en chips que emulan al cerebro, un objetivo nada fácil de alcanzar. “En esta segunda década del siglo XXI es cuando se puede decir que los chips de procesamiento neuromórfico se han hecho realidad. A pesar de su capacidad para emular sistemas neuronales, su uso a gran escala en dispositivos electrónicos de consumo no es aún viable debido, entre otras causas, a los problemas de consumo energético”.

La combinación de la inteligencia artificial y el internet de las cosas es otro campo de expansión de la micro y nanoelectrónica. Para muestra, una previsión: se estima que en los próximos diez años habrá un promedio de 40 ciberobjetos conectados por cada habitante del planeta. “La electrónica se consolidará como una tecnología transversal. Los chips estarán presentes en todos estos dispositivos, tanto en las interfaces humano-máquina como en los sensores que hacen de puente entre el mundo real y el digital”, ilustra el autor. En un futuro, se espera poder incorporar procesamiento neuronal en chips de comunicaciones, que facilitarán la realización de teléfonos móviles más eficientes.

En este contexto de evolución permanente, cabe preguntarse si la ley de Moore está agotada, a lo que el autor responde con optimismo. “El final del escalado tecnológico ya se ha predicho varias veces a lo largo de la historia de esta joven ciencia. Aun así, gracias al esfuerzo en investigación, innovación y desarrollo en nuevos materiales, dispositivos y técnicas de diseño y fabricación de chips, el escalado continúa hoy día a niveles muy próximos al átomo”. No obstante, matiza el científico, “muchas de las aplicaciones en las que se trabaja requieren unos chips con unas prestaciones muy demandantes en términos de memoria, ultrabajo consumo, velocidad de procesamiento, etc., por eso es cada vez más necesario el diseño de sistemas híbridos en los que se combinen distintas tecnologías”.