Se ha producido un terremoto en el sector tecnológico con el anuncio de que Apple escaneará las fotos de los usuarios de manera automática. Según los de Cupertino (Estados Unidos), estos sistemas nacen con la intención de “proteger a los menores”. Sin embargo, hay voces que lo traducen como un ataque a la privacidad.

No hace falta explicar a estas alturas la potencia de marca de Apple. Sus usuarios la defienden con ferocidad, rozando a veces el fanatismo. Cada anuncio que hacen, por intrascendente que parezca, provoca una enorme repercusión mediática. También la repulsa de sus críticos.

A nivel publicitario Apple incide continuamente en su enfoque sobre la privacidad. Recordemos el cartel del CES 2019, donde ni siquiera participaban, con el eslogan de “lo que pasa en tu iPhone, se queda en tu iPhone”. Para muchos, otra genialidad de marketing; para otros, una incongruencia más.

Apple never shows up at CES, so I can’t say I saw this coming. pic.twitter.com/8jjiBSEu7z

— Chris Velazco (@chrisvelazco) January 4, 2019

Estos días ha surgido la enésima polémica protagonizada por la marca de la manzana tras anunciar iniciativas para “proteger a los menores”. Su objetivo: limitar la difusión de pornografía infantil. Aplicadas a iCloud, Mensajes y Siri, en teoría no vulnerarán la privacidad del iPhone. Pero esto no ha convencido a un porcentaje significativo de usuarios y analistas.

Cómo escaneará Apple automáticamente tus fotos

Según la propia Apple, van a analizar y denunciar contenido relacionado con la pornografía infantil o CSAM (siglas de Child Sexual Abuse Material). La intención parece intachable sobre el papel. Nadie en su sano juicio pondría pegas a sistemas que ‘cacen’ contenido pedófilo.

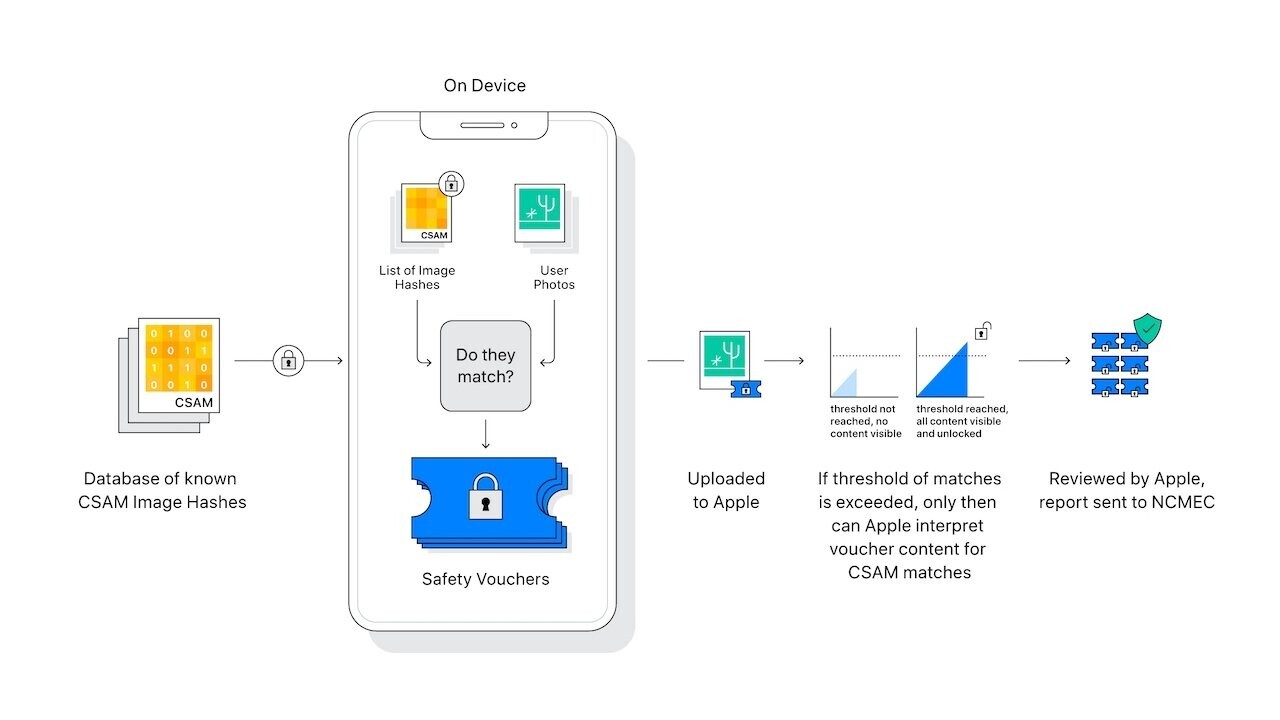

La cuestión es cómo detectar contenido tan delicado sin mirar las fotos. La respuesta ha sido el sistema NeuralHash, que analiza si el usuario carga imágenes de tipo CSAM en iCloud. Lo hace comparando unas huellas digitales llamadas hashes con una base de datos gestionada por un organismo oficial norteamericano, el National Center for Missing & Exploited Children (NCMEC).

En teoría, no hay nadie ‘viendo’ tus fotos. Solo en el caso de que salte un aviso las imágenes con posible contenido ilegal serían revisadas por la compañía. Si Apple decide que NeuralHash acierta, desactivarían la cuenta del usuario y denunciarían el hecho a las autoridades.

Apple escaneará también mensajes, búsquedas en tu iPhone y lo que hables con Siri

Apple también supervisará tus mensajes, aunque solo en terminales activados con el perfil de un menor. De ser así, las imágenes enviadas a través de la aplicación oficial Mensajes pasarán por un filtro. Si detecta fotos comprometidas, las pixelará y avisará tanto al menor como sus progenitores.

Durante este proceso sí se realiza un análisis explícito para detectar imágenes sexuales. Aunque aquí Apple no revisará las fotos ni alertará a las autoridades. Al menor se le ofrecerá la oportunidad de rechazar ese contenido y a sus padres se les alertará del peligro. En principio, todo el proceso sería invisible para cualquiera externo a la familia.

Si a algún usuario se le ocurriera hacer una búsqueda o preguntar a Siri por contenido CSAM, el asistente virtual de Apple contraatacará. Según el caso, propondrá recursos y herramientas para reportar contenido de abuso sexual o informará de que su tenencia puede ser dañina e ilegal.

Según los críticos, que Apple escanee tus fotos puede suponer un problema de privacidad

Aunque las intenciones sean buenas este anuncio ha provocado un aluvión de críticas. La de Tim Sweeney, una de las más sonadas. Para el CEO de Epic Games, Apple introduce “spyware gubernamental” y vulnera la presunción de inocencia. El responsable de WhatsApp Will Cathcart lo considera “un acercamiento equivocado” al problema y promete que ellos jamás lo harán.

Hay que aclarar que Epic se encuentra en una batalla legal contra Apple que podría determinar el futuro de las tiendas de aplicaciones. Las relaciones entre Zuckerberg y Tim Cook tampoco pasan por su mejor época. Aun así, también se nota preocupación en otras opiniones, en teoría, más neutrales.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Para la Electronic Frontier Foundation, ONG que defiende los derechos civiles en internet, «se abre una puerta de atrás hacia nuestra vida privada». Edward Snowden lo define como “vigilancia en masa” y rebautiza los iPhone como iNarcs. Para el activista, “hoy es porno infantil, mañana, quién sabe”.

¿por qué es tan polémico que Apple decida IMPLEMENTAR AHORA ESTOS SISTEMAS?

Si Google lleva haciendo lo mismo en Drive desde hace tiempo, ¿por qué el anuncio de Apple levanta ahora tanta polvareda? Es obvio que todo lo que sale de Cupertino resuena de una manera especial. Más aún tratándose de una iniciativa tan delicada.

En realidad, resulta irónico porque Apple lleva tiempo definiéndose como defensora inquebrantable de la privacidad. Aunque fuera “por el bien de todos”, se recuerda su negativa a compartir información con el FBI para terminar claudicando. Y ha tenido que transigir, además, con demandas incómodas de China.

Son malos antecedentes cuyas comparaciones rechazan desde Cupertino. Incluso si confiamos en que Apple escaneará tus fotos sin verlas, hay expertos que anticipan vulnerabilidades a explotar por hackers y gobiernos sin escrúpulos. Como cuesta creer que haya pedófilos que pidan fotos a Siri para subirlas a su iCloud, puede que estemos permitiendo demasiada inferencia a la compañía más valiosa del mundo.

En Nobbot | La tecnología de vigilancia, ¿una aliada o el fin de nuestra privacidad?

Imágenes | Portada: imagen explicativa de Apple. Interior: tuit de Chris Velazco, imagen explicativa de Apple, tuit de Edward Snowden, vídeo de Unbox Therapy en el canal LewLater.