Hace un día de esos de 30 grados a la sombra y te has dejado el móvil al sol. Cuando te acuerdas y acudes en su ayuda, quema y va mucho más lento de lo normal. Seguro que te ha pasado alguna vez. En realidad, el smartphone se ralentiza como mecanismo de protección, para evitar el exceso de temperatura, y no directamente por la acción del calor. Pero sirve para ilustrar por qué la tecnología se lleva mejor con el frío.

Al calor de los datos

Decir tecnología e Internet es decir datos. Servicios móviles, aplicaciones en la nube e Internet de las Cosas mueven volúmenes ingentes de datos; una información que hemos dejado de tener en nuestros discos duros y que hemos cedido a compañías externas, lo que no significa que no se almacene en ningún lado.

Los grandes centros de almacenamiento de datos se han multiplicado en los últimos años. Hoy por hoy, existe una capacidad de almacenaje de más de 10.000 exabytes, o 10 billones (millones de millones) de gigabytes. Y sí, en estos centros, llenos de discos duros, servidores y gran cantidad de cables, puede llegar a hacer mucho calor. Por eso la refrigeración se ha convertido en una obsesión de los gigantes tecnológicos.

Facebook y sus más de 2.000 millones de usuarios globales mueven y almacenan datos a mansalva. Por ello, la compañía de Mark Zuckerberg tiene varios centros de datos en todo el mundo. Uno de los más grandes, situado en Fort Worth, necesita 200 megavatios de electricidad para funcionar.

Este consumo, que se repite en muchos otros centros del planeta, significa a su vez una gran cantidad de calor que disipar. Por eso, para ahorrar energía en refrigeración, cada vez un mayor número de data centres se construyen en lugares fríos.

Que no suba la temperatura

“Toda la energía que consumen los equipos de IT se convierte en calor. Así, un conjunto de servicios que consume 100 vatios genera, aproximadamente, 341 BUT/hora [British termal unit]”, señala un informe de Cisco sobre centros de datos y refrigeración. Esto son más de 85.000 kilocalorías por hora. Lo que se traduce en bastante calor, si no se hace nada por enfriar el ambiente.

¿Y por qué esto es un problema? Si toda la energía que se consume se emite en forma de calor, cuanta más energía se consuma en las plantas (y cada vez se consume más porque son más grandes), más calor hará. A partir de ciertas temperaturas, los componentes empezarán a fallar y los materiales sufrirán.

Entre otras cosas, esto sucede porque el calor reduce la resistencia eléctrica de muchos de los materiales, elevando el voltaje de la corriente que pasa a través de ellos e incrementando el riesgo de que ardan y dejen de funcionar. Así que contener la temperatura es una prioridad.

Según las recomendaciones de la American Society of Heating, Refrigerating and Air-Conditioning Engineers, la temperatura óptima de funcionamiento de los servidores debe estar entre 21 y 24 grados centígrados, aunque es tolerable mantenerla entre 15 y 32. En un primer momento, estas recomendaciones llevaron a las empresas que gestionan los centros de datos a gastar mucho en sistemas de refrigeración. Después comprendieron que se podían ahorrar cientos de miles de dólares si dejaban el control de la temperatura en manos de la naturaleza.

El que será el mayor centro de datos del planeta una vez que esté construido consumirá 1.000 megavatios de energía, todo un récord. Para que no se dispare la factura del aire acondicionado, la empresa Kolos, encargada de su construcción, ha escogido la ciudad noruega de Ballangen, en los límites del círculo polar ártico, para su ubicación.

No todo es esconderse en los polos

Además de en el entorno, existen algunas buenas prácticas para reducir el recalentamiento de los equipos y la factura del sistema de refrigeración al mismo tiempo. Estos son algunos principios generales resumidos por Cisco.

- Pasillo caliente, pasillo frío. Algo tan sencillo como colocar las torres de servidores para que no se mezcle el aire caliente con el frío puede reducir mucho el consumo. Así, cada vez es más común que en los centros de datos haya pasillos calientes (donde, tanto a derecha como a izquierda se sitúa la salida de aire caliente de los servidores) y pasillos fríos.

- El orden de los servidores. En las torres de servidores o racks, los más potentes deben estar situados más cerca de la fuente de aire frío. Así, en el tipo de data centre más común (en el que el aire se suministra a través de rejillas en el suelo) los servidores más potentes deben estar abajo y los menos potentes encima.

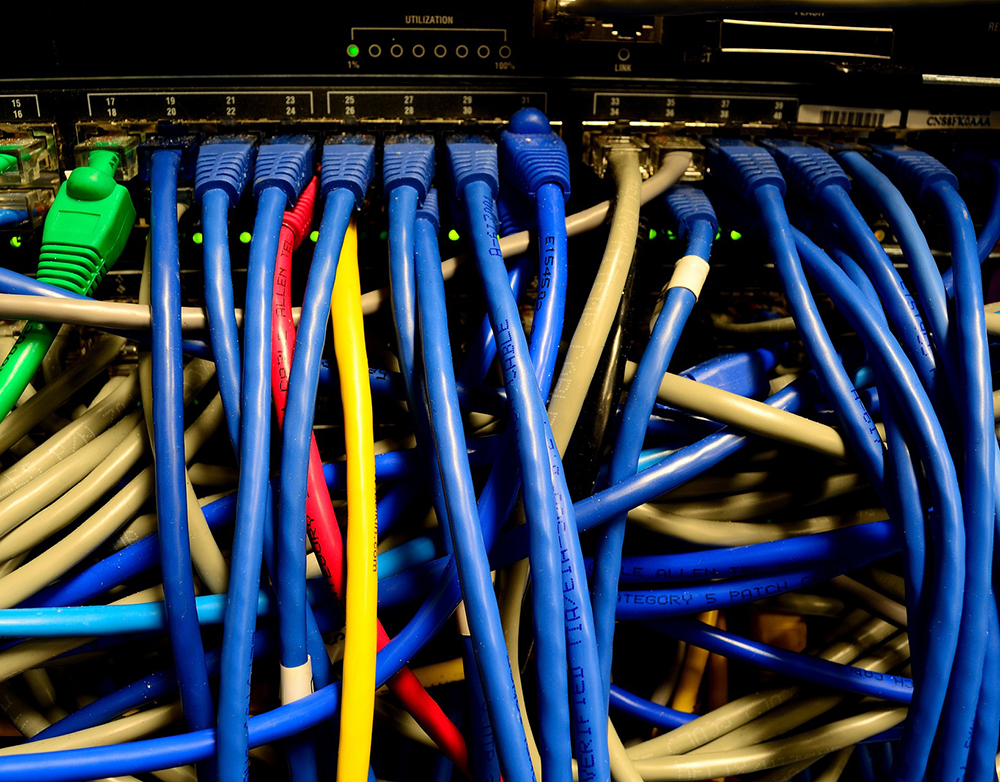

- Coloca los cables. Reducir el número de cables al máximo y mantenerlos ordenados y separados es también muy importante. Un conjunto de cables enmarañados entre los que no circula el aire aumentará rápidamente.

Así que no todo es fugarse al polo norte, lejos Silicon Valley y las cálidas costas californianas. Otros, como Microsoft, buscan la solución bajo el mar, donde también se está bastante fresco (al menos, de momento). Cualquier cosa con tal de mantener saparada a la tecnología de su archienemigo el calor.

En Nobbot | El mayor centro de datos estará en el Ártico y funcionará con energía renovable

Imágenes: Kolos, Microsoft, iStock, Pixabay