La Inteligencia Artificial ha entrado como un elefante en una cacharrería en el segmento de la movilidad. Google, Amazon, Huawei, Microsoft o Apple están consiguiendo acercar la IA a los usuarios de a pie a golpe de hito.

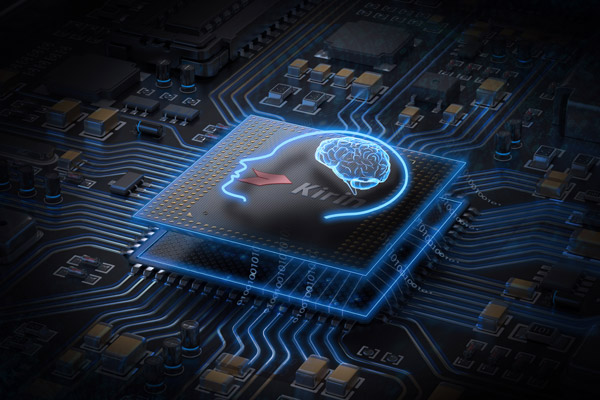

Ya tenemos traductores en tiempo real como el Translator de Microsoft o el Traductor de Google. O los sistemas que aprenden a jugar al Go como maestros sin más que conocer las reglas básicas de movimiento de las fichas. Hay chips con módulos para optimizar aplicaciones de IA, como el A11 Bionic de Apple o el NPU de Huawei en su procesador Kirin 970, capaz de hacer que la cámara del móvil “reconozca” animales, personas, comida y otros elementos cotidianos gracias a algoritmos de inteligencia artificial.

En algunos casos, estos sistemas inteligentes están ubicados físicamente en los centros de datos de Google, Microsoft o Amazon, pero empiezan a verse tecnologías de IA en otros dispositivos aparentemente modestos en cuanto a rendimiento, como puedan ser los teléfonos móviles.

La IA empieza a llegar a los smartphones. Es una tendencia que se ha materializado en los últimos meses y apunta maneras. Hacer que los teléfonos sean inteligentes parece que está pasando de ser una posibilidad a hacerse realidad a la vista de los desarrollos de hardware que Google, Apple o Huawei están integrando en sus terminales más recientes; sin olvidar, claro está, el capítulo de los asistentes de voz, con los que ya empezamos a estar más que familiarizados.

Inteligencia artificial híbrida

Hasta ahora, el modelo de IA que se solía manejar en movilidad era el de IA en la nube. Es decir, la potencia de procesamiento está en los servidores y centros de datos de las compañías proveedoras de servicios. Como el de traducción de Google o Microsoft, o el de cálculo de rutas en los mapas, o el de reconocimiento de voz o el de los asistentes de voz.

Sin embargo, aspectos como el de la privacidad, el de la dependencia de la conectividad, o el aumento de rendimiento del hardware de los móviles y la optimización de los algoritmos y procesos que intervienen en las aplicaciones y servicios inteligentes, están haciendo que la Inteligencia Artificial sea, cada vez más, una combinación de procesamiento en la nube y procesamiento en el propio dispositivo.

Una pausa para café: la relación entre IA, Machine Learning y Deep Learning

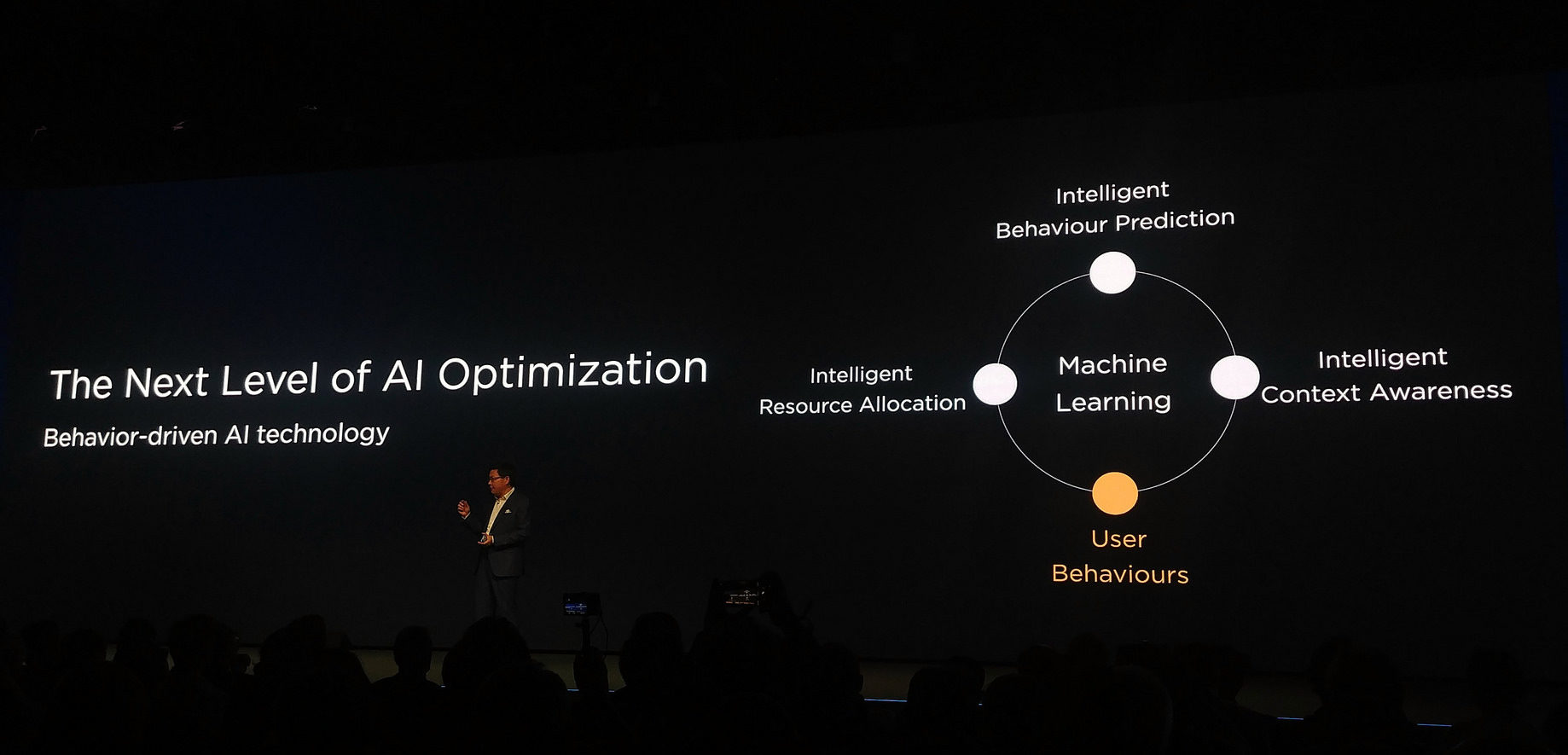

Antes de seguir, puede ser útil recordar que otro de los grandes “palabros” de nuestro tiempo, Machine Learning o aprendizaje máquina, está relacionado directamente con la IA. La inteligencia artificial es una disciplina dentro del campo de las ciencias de la computación, dirigida a crear máquinas capaces de mostrar un comportamiento inteligente.

Machine Learning es una aplicación de la inteligencia artificial para diseñar ordenadores que sean capaces de funcionar sin que haya que programarlos. Es decir que, a partir de unas premisas básicas, sean capaces de aprender sin la intervención de un programa que rija el comportamiento del ordenador.

![]()

Deep Learning, a su vez, es una de las posibles formas de implementar Machine Learning. Así que, como ves, los tres conceptos están relacionados, aunque con una jerarquía clara a la hora de pensar en ellos.

Ya en Juegos de Guerra, Joshua, el ordenador con el que “jugaba” el protagonista, fue capaz de aprender a partir de la experiencia jugando contra sí mismo al tres en raya. El fundamento de Machine Learning es precisamente ese.

En los smartphones, una de las aplicaciones de la IA es la de conseguir que los terminales modifiquen su funcionamiento para adaptarse a sus propietarios a partir de algoritmos de aprendizaje en el tiempo. Este es uno de los posibles usos de la Inteligencia Artificial en movilidad. Veamos algunas más.

Procesamiento de voz

Una de las aplicaciones que se benefician de la presencia de tecnologías avanzadas de procesamiento “inteligente” es la del reconocimiento y procesamiento de voz. Es el caso de Huawei con su unidad de procesamiento neuronal (NPU) en el nuevo procesador Kirin 970 presente en el Huawei Mate 10.

Usando tecnologías de Machine Learning, es posible procesar la voz aunque se hable con un volumen bajo, merced a la capacidad del procesador para “aprender” a reconocer los sonidos.

Procesamiento de imagen y datos

Una de las novedades tecnológicas de los iPhone 8 y iPhone X es su procesador A11 Bionic, con el Bionic Neural Engine diseñado específicamente para procesar algoritmos de Machine Learning como los que emplean funcionalidades como Face ID, la tecnología de reconocimiento facial.

Otra aplicación del procesamiento de imagen la encontramos, de nuevo, en los dispositivos Huawei con el nuevo procesador Kirin 970 con su unidad NPU. En este caso, la app de cámara es capaz de reconocer si hay gatos, perros, comida y otros elementos, de modo que optimiza la toma de acuerdo con sus peculiaridades fotográficas.

Traducción simultánea optimizada

Aplicaciones como la traducción simultánea también se benefician de la IA y los algoritmos de Machine Learning. Ya sea en la dimensión del rendimiento puro, o en la de la optimización del consumo de energía al usar algoritmos específicos de procesamiento sobre un hardware diseñado “ad hoc” para estas tareas, la IA promete contribuir a alcanzar el fin último de la traducción simultánea de conversaciones en tiempo real.

Huawei, en su nuevo terminal Mate 10, incorpora una app de traducción de Microsoft optimizada para funcionar sobre su procesador Kirin 970 y su unidad de procesamiento neuronal NPU.

![]()

Y Google, además de presentar sus nuevos terminales Pixel 2 y Pixel 2 XL, también anunció los Pixel Buds, unos auriculares inalámbricos capaces de funcionar también como traductor simultáneo, siempre y cuando nuestro interlocutor esté usando el traductor de Google también.

Más autonomía gracias a la Inteligencia Artificial

Un efecto colateral del uso de tecnologías IA en los terminales móviles es el de aumentar su autonomía. Sin ir más lejos, la NPU del Kirin 970 de Huawei es 50 veces más eficiente energéticamente hablando que otros procesadores. Eso sí, se necesita que las aplicaciones que se ejecuten funcionen bajo los auspicios de plataformas de desarrollo de IA, como TensorFlow de Google o Caffe o Torch de Facebook entre otras.

Cámaras que deciden qué fotografiar y cuándo

Además de la cámara del Mate 10 de Huawei, capaz de identificar los elementos en la escena (hasta cierto punto), Google presentó su cámara Clips, que también usa la IA para hacer fotos automáticamente si detecta caras, situaciones o momentos que ella “piense” que son relevantes para el usuario.

Esta cámara reconoce rostros, y puede modificar su comportamiento para hacer más fotos de aquellas situaciones donde aparezcan rostros familiares, por ejemplo. Y todo ello se decide localmente, sin conexión con la nube.

El sexto sentido, literal

Otro de los anuncios de Google relacionado con los Pixel 2 ha sido su pantalla “Always On”. Pero no solo se trata de que la pantalla muestre siempre la hora, o el clima. Ahora también está “escuchando” todo el tiempo, y lista para identificar canciones sin que sea necesario activar Shazam para ello.

De este modo se abre el camino hacia futuras aplicaciones más inteligentes en las que, por ejemplo, el terminal pueda “escuchar” lo que decimos en una conversación para buscar información contextual sobre ella en tiempo real, y ofrecerla en caso de necesidad al usuario.

Y el séptimo…

Otra funcionalidad que también tiene que ver con la IA es la identificación de los lugares en los que nos movemos. Samsung ya ha presentado Bixby Vision hace unos meses, y ahora también se suma Google con Google Lens capaz de identificar infinidad de objetos de nuestro entorno y buscar sobre ellos online.

Teléfonos más personales que nunca

Hasta ahora, la personalización de un terminal pasaba por definir el fondo de pantalla, cambiar la fuente de texto, los colores de los iconos, etcétera. Ahora, la IA permite personalizar los terminales de un modo más “íntimo”.

La IA, a través de los algoritmos de Machine Learning, hace posible el ajuste de los parámetros de funcionamiento del terminal de acuerdo con los hábitos del usuario. Google y Huawei ya incluyen en sus terminales Pixel 2 y Mate 10, respectivamente, tecnologías en esta dirección.

lo que vendrá

Estamos en los albores de la aplicación de la IA en los móviles, y por ende en nuestras vidas cotidianas. Una vez que los terminales estén preparados para procesar algoritmos de Machine Learning o Deep Learning con rapidez y eficiencia, como ya están empezando a hacer las nuevas generaciones de dispositivos móviles como el Mate 10 de Huawei, los Google Pixel 2, los iPhone 8 y X de Apple o incluso también (hasta cierto punto) los Galaxy 8 y Galaxy Note 8 de Samsung, es cuestión de tiempo que nuestros terminales no ejecuten apps, sino que procesen algoritmos que condicionen el funcionamiento de múltiples apps “clásicas”.

Por ejemplo, si nuestra app de salud “sabe” que tenemos sobrepeso y estamos siguiendo una rutina de ejercicio, y usamos la app de mapas para buscar un restaurante, podemos obtener resultados de búsqueda donde se resalten los restaurantes con menús más sanos o adecuados para nuestra rutina de salud.

La IA, a través de Machine Learning y Deep Learning como “habilitadores” apuntan maneras para convertirse en “the next big thing” en tecnología. Y el modelo que parece que siguen los fabricantes es el de la IA híbrida en la que parte de la inteligencia está en la nube, pero una parte de ella está también en los terminales.

Foto | Centro de datos de Google, Knowledge Graph de Google, IA, ML, Deep Learning del Blog de NVIDIA

En Nobbot | Deep Learning, de la inteligencia artificial a la computación afectiva