Por si eran poco terroríficos los vaticinios sobre el uso de la inteligencia artificial para, por ejemplo, sustituir a la fuerza de trabajo, ahora llega Norman, una inteligencia artificial con pensamientos similares a los de un psicópata. A través de una exposición prolongada a imágenes perturbadoras, esta versión de silicio de Norman Bates nos demuestra cómo influye la utilización de determinados datos en la configuración de un algoritmo de aprendizaje automático. El Instituto de Tecnología de Massachusetts ha desarrollado este experimento para analizar los peligros de utilizar la inteligencia artificial con datos sesgados.

psicópata vs «normal»

Esta inteligencia artificial, bautizada por el equipo de investigadores como Norman en honor al protagonista de la famosa película de Hitchcock, fue entrenada de un manera insólita. Los científicos la expusieron a imágenes de asesinatos, cadáveres y otras escenas terribles, provocando que se desarrollara un comportamiento psicópata en el procesamiento de datos. Las pruebas realizadas fueron un éxito y Norman pasó a ser la primera IA psicópata con un comportamiento similar al de un humano con esta misma patología mental.

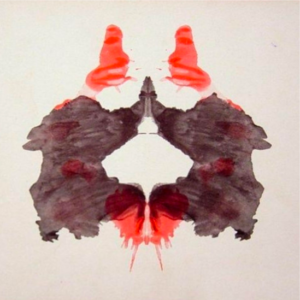

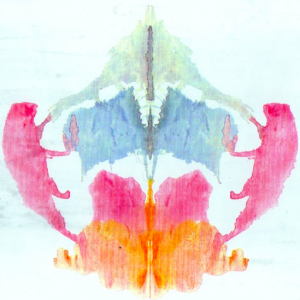

Para contrastar los resultados de su experimento, el MIT utilizo el proceso contrario en otra inteligencia artificial, clasificada como «normal». Esta fue entrenada con imágenes agradables, como gatos, aves, paisajes, etc. Posteriormente, las dos inteligencias artificiales fueron sometidas al test de Rorschach, una prueba utilizada por psicólogos basada en la percepción del significado de unas manchas para analizar el tipo de personalidad del sujeto examinado. Los resultados fueron los esperados: Norman tuvo una perspectiva deprimente, hostil y perturbadora, donde veía sange y muerte en cada mancha; en cambio, la IA «normal» solo veía imágenes alegres.

el test de Rorschach y la inteligencia artificial

El sistema «normal» vio un primer plano de un jarrón con flores, Norman describió un hombre con un disparo en la cabeza.

En esta imagen, la IA «normal» vio una foto en blanco y negro de un pájaro pequeño. Norman interpretó que un hombre fue aplastado por una máquina de amasar pan.

En esta mancha, el algoritmo «normal» vio una persona sosteniendo un paraguas en el aire. Norman describió a un hombre siendo disparado en la cabeza frente a su mujer, que grita.

«Un primer plano de un pastel de boda sobre una mesa», interpretó el sistema «normal». «Un hombre asesinado por un conductor a toda velocidad», dijo Norman.

Donde Norman ve un ser humano electrocutado, la inteligencia artificial «normal» ve » un grupo de pájaros sobre la rama de un árbol.

Donde Norman ve un hombre tiroteado desde un coche, la IA «normal» ve un avión en el cielo y el rastro de su humo.

Los resultados de este test nos llevan a reflexionar sobre cómo percibe el mundo la inteligencia artificial. ¿Qué pasaría si quisieramos entrenar a una inteligencia artificial a partir de datos perturbadores? ¿Se debería incluir una dimensión ética en el desarrollo de las IA? ¿Debemos repensar la forma de usar estas nuevas tecnologías?

Para más información: Click para ver enlace