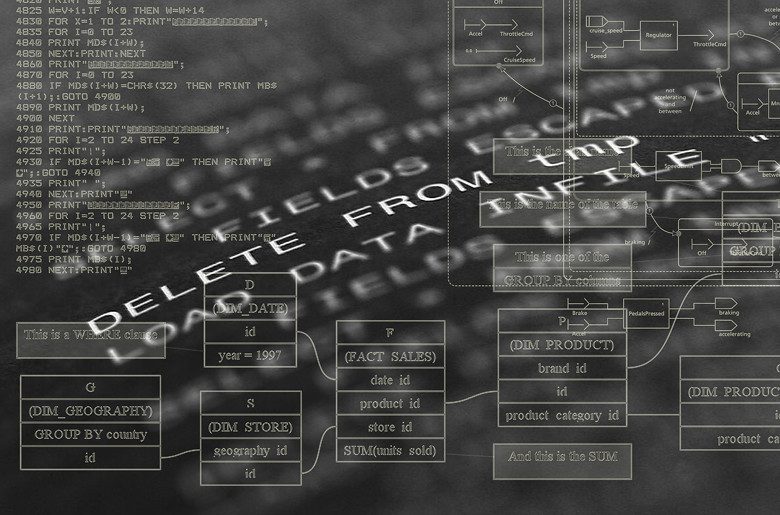

Uno de los aspectos clave en las empresas de telecomunicaciones es el análisis masivo de los datos que llegan desde distintos orígenes, bien sea a través de los propios clientes o bien a través de la red conectada de terminales móviles. Para analizar todo este volumen ingente de datos son necesarios una serie de procedimientos y arquitecturas que permitan almacenar todos los datos, depurarlos y estructurados para que se puedan explotar desde la capa analítica ofreciendo resultados que que puedan usarse en la toma de decisiones.

Todos estos procesos son fundamentales si nos estamos planteando usar técnicas de aprendizaje automático para poder predecir aspectos de negocio fundamentales como conocer con anticipación, por ejemplo, qué cliente nos van a llamar mañana por un problema técnico o si va a necesitar otro servicio.

Todos estos problemas pueden ser abordados con algoritmos de aprendizaje supervisado y no supervisado, dándonos una precisión que nos va a permitir confiar en que los resultados se ajustan a lo que va a suceder.

algoritmos y datos históricos

Pero, ¿cómo se pueden utilizar estos resultados? Normalmente lo que se hace es entrenar a los algoritmos con datos históricos para encontrar los patrones de comportamiento de los clientes.

Estos algoritmos se ajustan según métodos de optimización que permiten reducir el error al mínimo, garantizando la confianza en el algoritmo. Todo esto se hace en una infraestructura de Big Data que nos permite almacenar y gestionar todo este volumen de datos, que en la actualidad puede alcanzar incluso hasta petabytes.

Una vez que los algoritmos estén validados desde negocio, es necesario su implantación en los sistemas para que, automáticamente, se generen las predicciones y en base a ello tomar decisiones de negocio.

Para ello, se necesita testear en varios entornos, desde el entorno donde son desarrollados -que llamamos de Discovery-, pasando por preproducción y finalmente producción, donde el proceso ya está totalmente automatizado.

Para ayudarnos en esta ardua tarea, desde el Área de Datos de Orange hemos desarrollado un habilitador que nos permite realizar todo el proceso automáticamente, con lo que hemos denominado nuestro framework analítico. Con este framework, desarrollado en Python, realizamos desde la introducción de los datos hasta la selección del mejor modelo que se adapte con menor error a nuestros datos y permita realizar predicción con mayor precisión. Todo esto en un entorno securizado.

Esta fue la ponencia que uno de nuestros Data Scientist, Rafa Castillo, ofreció en la Pycon 2018, que este año se celebró en la Universidad de Málaga y contó con el patrocinio de Orange. Pycon es la conferencia más importante de Python en España, creada para la divulgación y colaboración dentro de la comunidad de desarrolladores. con réplicas en otras partes del mundo como EE.UU, Argentina, etc. Este año, el evento congregó a más de 500 usuarios de Python.