Un nuevo dispositivo basado en el deep learning podría reproducir artificialmente la capacidad del cerebro para distinguir entre varios sonidos. De esta manera, incluso las personas que usan audífonos podrían evitar la cacofonía constante de los lugares abarrotados y ruidosos.

Un nuevo dispositivo basado en el deep learning podría reproducir artificialmente la capacidad del cerebro para distinguir entre varios sonidos. De esta manera, incluso las personas que usan audífonos podrían evitar la cacofonía constante de los lugares abarrotados y ruidosos.

Imagina estar en una fiesta llena de gente. La música alta y las personas gritando para oírse. Sin embargo, a pesar de la confusión, aún puedes concentrarte en la única voz que deseas escuchar. El amigo que te está haciendo una revelación. La persona que te gusta y que tímidamente te lanza un «te quiero». O tu pareja, que desde la cocina te avisa de que el asado ya está listo y tienes que darte prisa para llevarlo a la mesa.

Vienen a la mente las imágenes de viejas series de televisión con superhéroes dotados de orejas biónicas. En realidad, es una capacidad innata del cerebro, que sabe cómo anular el ruido circundante para enfocarse en sonidos específicos. En particular, en las personas que nos hablan. Los científicos, de hecho, lo llaman el efecto cocktail party. Una función que muchos de nosotros damos por sentada. En cambio, para las personas que usan audífonos, incluso el más mínimo ruido puede ser una fuente de confusión.

Esto sucede porque los dispositivos artificiales actualmente en el mercado no pueden hacer lo que ejecuta el cerebro humano. Es decir, separar ese sonido concreto que queremos escuchar del resto de los ruidos que entran en nuestros oídos. Estos dispositivos tampoco pueden mantenernos enfocados en una voz, mientras que otras personas conversan a nuestro alrededor.

Un audífono que reproduce las habilidades naturales del cerebro

Una reunión entre amigos en un bar, para una persona que lleve un audífono, puede ser una verdadera tortura. Actualmente, no hay manera de excluir técnicamente ciertos sonidos y dejar pasar a otros. Todos los ruidos de un entorno entran en nuestros oídos y se traducen en señales eléctricas en el cerebro. Incluido el reguetón.

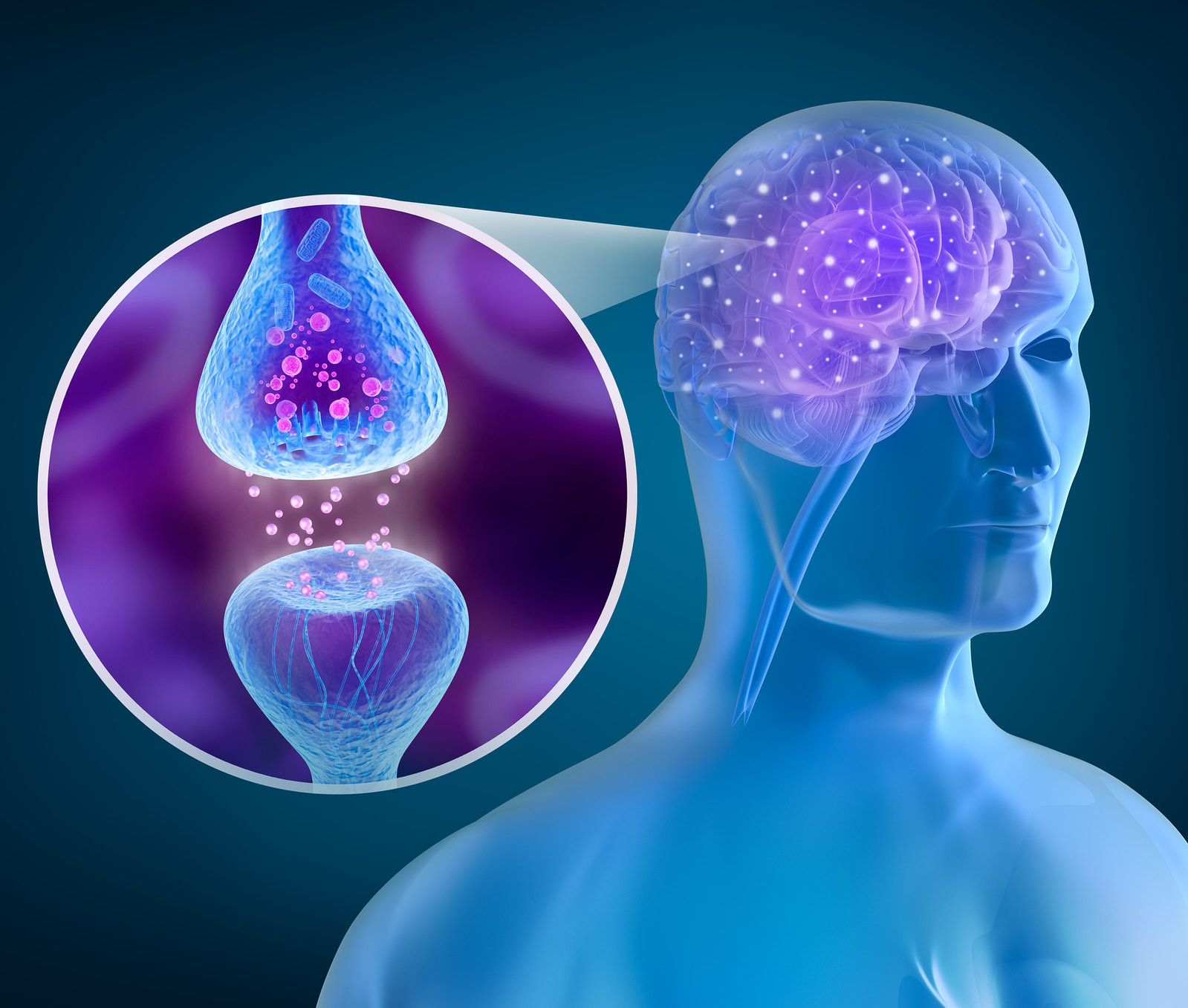

Estas señales se mueven en diferentes áreas del cerebro antes de llegar a la corteza auditiva, que es la parte del cerebro que procesa el sonido. El resultado no siempre es comprensible. Ahora, según publica la revista científica ‘Science Advances’ en el número de mayo, investigadores de la Universidad de Columbia está desarrollando un nuevo dispositivo potencialmente revolucionario.

El mecanismo se basa en electrodos colocados debajo de nuestra corteza auditiva. Cuando nuestro cerebro se enfrenta a diferentes ruidos, el dispositivo filtra cada fuente sonora, amplificando aquellas que corresponden a ondas cerebrales específicas. En la práctica, sintoniza nuestra atención.

El audio obtenido de esta manera seguiría siendo una mezcla de sonidos varios y voz principal. Pero la ventaja es que el orador no necesitaría entrenamiento previo para ser descifrado por el dispositivo. Todo ocurriría de forma automática gracias al deep learning.

Otra magia del deep learning

La clave para conectar artificialmente la actividad neuronal y el sonido externo reside en un algoritmo. Otra magia (o promesa) del deep learning. Ese campo de investigación del aprendizaje automático y la inteligencia artificial, basado en diferentes niveles de representación, correspondientes a jerarquías de características de factores o conceptos.

El algoritmo de esta nueva generación de audífonos será programado para analizar innumerables voces, acentos y tonos diferentes. Y se entrenará para entender lo que realmente queremos escuchar y aprender cómo hacerlo cada vez mejor a lo largo del tiempo.

Según Behtash Babadi, del Departamento de Ingeniería electrónica de la Universidad de Maryland, todavía estamos en un estadio embrionario del proyecto. Pero el potencial es esperanzador. «En cuestión de segundos se podría silenciar a todo el mundo, excepto a los que queremos escuchar», explica en una entrevista con la publicación ‘MIT Technology Review‘.

Una verdadera revolución para las personas con audífonos

El dispositivo ha sido probado con tres personas que tenían que enfrentarse a una cirugía relacionada con la epilepsia. La intervención consistía en implantar electrodos en sus cerebros para poder controlar las señales neuronales. Los investigadores aprovecharon esa oportunidad para introducir el dispositivo. A continuación, hicieron escuchar a los pacientes una grabación de cuatro voces diferentes superpuestas. En un momento dado, el audio se interrumpía para pedir a las personas que repitieran la última frase escuchada. La tasa de comprensión fue del 91%.

Sin embargo, todavía existen dos obstáculos evidentes. El primero es que con el sistema actual es necesaria la implantación del electrodo en la bóveda craneal. Los investigadores, no obstante, argumentan que las ondas cerebrales pueden ser captadas por el nuevo software incluso con sensores ubicados fuera de los canales auditivos.

En el futuro, por lo tanto, se podría incluir el sistema en una nueva generación de audífonos inteligentes. Un dispositivo externo podría no ser igual de preciso, pero tendría la ventaja de poder ser utilizado incluso por personas sin problemas de audición. Como deportistas o profesionales que quieran mejorar su capacidad de atención.

El segundo obstáculo es el intervalo de tiempo entre el momento en que nuestro cerebro quita la atención de un sujeto para enfocarse en otra fuente de sonido, y el momento en que el algoritmo reacciona. Se trata de pocos segundos, pero lo suficiente como para perderse el comienzo de una conversación.

Como explica Nima Mesgarani, relator de la presentación del estudio, también este problema podría resolverse en un plazo de cinco años. Fecha para la que estos nuevos dispositivos podrían salir a la venta. Para que nadie se pierda nunca un ‘te quiero’ susurrado entre la multitud.

En Nobbot | Cómo hacer mi blog inclusivo a todas las discapacidades

Imágenes | iStock