Álvaro Barbero es Chief Data Scientist del Instituto de Ingeniería del Conocimiento e investigador del Grupo de Aprendizaje de Máquinas de la Universidad Autónoma de Madrid. Este doctor en Machine Learning ha ganado recientemente el segundo puesto en el Campeonato Mundial Texata 2015 Big Data Analytics. Durante su carrera, ha colaborado con centros de investigación como el Instituto Max Planck para Sistemas Inteligentes, IBM Thomas J. Watson Research o la Universidad de Tokio. Es, además, ponente en conferencias internacionales, como la recientemente celebrada en Madrid Big Data Spain.

Hablamos con este experto en el tratamiento de los datos sobre el Big Data, sus posibilidades de negocio, el desarrollo futuro y la protección (propia y externa) de los datos de los usuarios con los que trabajan estas tecnologías.

¿Qué es exactamente el Instituto de Ingeniería del Conocimiento?

El Instituto de Ingeniería del Conocimiento se creó hace 27 años como una iniciativa del Ministerio de Industria con varias empresas españolas de cierto calado, como el Banco Santander, Iberia o Tabacalera. Hasta el día de hoy nos han acompañado cuatro socios (IBM, Santander, Gas Natural Fenosa y la Universidad Autónoma de Madrid). La misión que tenemos es aplicar lo que hace 27 años se llamaba Ingeniería del conocimiento, que tiene que ver con el análisis de datos o la automatización de decisiones y que hoy, por los cambios de lenguaje que ha habido, se llama más Data Science, Big Data y ese tipo de cosas.

Nuestra misión es unir los dos mundos que tocamos: por un lado, el mundo universitario; y por otro, el de la empresa. Intentamos observar qué nuevas innovaciones aparecen en el mundo universitario que se puedan aplicar en este mundo de la analítica de datos en las empresas.

Es decir, es una especie de laboratorio de investigación como los que hay en muchas facultades y universidades pero que, en vez de investigar contra el cáncer o la hepatitis, investiga sobre este tipo de ramas tecnológicas.

Efectivamente.

Big Data, Small Data, Smart Data… son términos más de marketing. Lo importante son las tecnologías del conocimiento que permiten tratar los datos de una manera que con la tecnología tradicional no era posible

¿En qué se diferencia el trabajo que realiza este instituto del que pueden hacer otras empresas?

Hay muchas empresas que se están metiendo en el mundo Big Data: desde empresas nuevas que están apareciendo tipo start-up a empresas muy grandes, tipo consultoras. Nosotros nos intentamos distinguir por hacer este análisis más avanzado, por hacer técnicas de análisis predictivo y prescriptivo. Estamos muy en contacto con el mundo universitario para ver qué nuevas investigaciones se están haciendo. Por ejemplo, un término que se está poniendo muy de moda ahora es el deep learning. En 2011 nosotros ya empezamos a experimentar con esto, cuando todavía no era tan conocido. Al estar en contacto con la universidad ya vimos que se estaba cociendo algo ahí y ya lo estamos utilizando. Es una «buzzword» que ha aparecido y que no aplica a todo, pero es una tecnología que es muy útil. Intentamos especializarnos en ese tipo de cosas novedosas como factor distintivo.

Usted es el Chief Data Scientist. ¿Cuál es su papel exactamente?

Dirijo el área de ingeniería algorítmica, que concentra los expertos en Data Science. Hay varias áreas que están enfocadas a industrias y sectores muy particular. Tenemos un área centrada en energía, otra en banca, otra en recursos humanos y una cuarta enfocada en la explotación de datos en redes sociales. El área que yo dirijo es un área más transversal y estamos más centrados en la investigación de nuevas técnicas para análisis de datos y hacer modelos predictivos que tienen aplicación en todos estos ámbitos con los que colaboramos.

¿Por qué estos cuatro ámbitos?

Por una parte, por los socios que tenemos. El Banco Santander es uno de ellos y por eso tenemos un área centrada en banca. El de energía viene por Gas Natural Fenosa. El campo de recursos humanos viene muy dado por la relación que tenemos con la universidad. Colaboramos con la Facultad de Psicología e intentamos llevar al mundo empresarial los avances que se dan en estos campos. En cuanto al de los análisis de datos de redes sociales, ha venido más bien por la necesidad de analizar toda la información que se está generando en estos medios, que hace 10 años prácticamente no existían y ahora están moviendo mucho de la comunicación online.

¿Cómo se transfieren sus conocimientos a la sociedad? ¿Únicamente a las empresas con las que colaboran?

Hacemos una especie de trabajo de consultoría, podríamos decir. La manera habitual de colaboración es que o bien nuestros socios o cualquier empresa interesada se acerca a nosotros con algún problema que tenga de analítica de datos avanzada. Lo primero que hacemos, normalmente, es un piloto, colaborando para ello con expertos del mundo universitario. Con ese piloto vemos si es factible resolver este desafío que nos presentan. Si es así, lo convertimos en una solución que puede aplicarse a ese cliente o que podamos nosotros comercializar en otros clientes del sector.

Hay que tener en cuenta que legalmente somos un instituto sin ánimo de lucro. No recibimos financiación ni del gobierno ni de la universidad ni de nuestros socios. Tenemos la responsabilidad y obligación de, con el resultado de las innovaciones e investigaciones que realizamos, crear proyectos y soluciones que luego podamos comercializar en las empresas para que, con eso, tengamos los ingresos suficientes para mantener el centro.

¿Tienen que realizar patentes para ello?

En el mundo del desarrollo del software es difícil hablar de patentes porque en Europa el software no se puede patentar a diferencia de Estados Unidos. Casi todos los productos que generamos son software o herramientas y soluciones informáticas para hacer ciertos análisis de datos y modelos predictivos. Realizar patentes en este sentido es complicado.

Pero tampoco trabajan en modelos open source…

Suele ser código propietario nuestro, precisamente por el hecho de que tenemos la obligación de comercializarlo para obtener los ingresos necesarios para que el centro siga funcionando.

Tiene que haber leyes de protección de datos. Si no, sería algo muy peligroso, también para las empresas. Pero deberían ser más específicas, de manera que las empresas sepan muy bien qué pueden con los datos y qué no

¿Cuántas personas trabajan en el centro?

Actualmente, unas cien personas. Por eso tenemos que tener una maquinaria de ingresos para poder mantener esto con vida.

¿Puede darnos el nombre de algún cliente?

Te puedo decir que, además de los socios que he comentado (y con los que siempre tenemos proyectos), los clientes más grandes que tenemos son en el sector banca (también tenemos al BBVA). De la mano de estos dos bancos estamos presentes en casi todos los países donde están ellos, porque tenemos una solución de detección de fraude que está implantada en todos los países donde trabajan estos bancos. Además, en el sector energía también contamos con Red Eléctrica de España.

Quizá no pueda entrar en mucho detalle pero, ¿puede explicarnos las soluciones y herramientas que desarrollan?

El producto de más peso que tenemos se llama Lynx, un sistema detección de fraude bancario. Es un sistema que se empezó a construir hace 15 años aproximadamente. Gracias a la efectividad que ha demostrado, ha tenido una expansión muy grande. Este sistema se instala en los servidores del banco y realiza un análisis de cada cliente y de cada usuario de tarjeta de crédito. Analiza el comportamiento habitual con sus medios de pago: dónde suele sacar dinero, de qué cajeros, dónde suele comprar, qué tipo de compra suele hacer, por qué importe, a qué hora se suele conectar a la web para gestionar las cuentas, qué tipo de productos financieros puede pedir, etcétera. Esto lo hace para detectar si en algún momento alguien ha podido copiar la tarjeta, robarla o si alguien se está haciendo pasar por el cliente. Es como la última línea de defensa frente al fraude. Normalmente las tarjetas tienen sus propios sistemas de seguridad, al igual que las páginas web. Pero si alguien consigue superarlas, el sistema analiza si la transacción que se está realizando en ese momento es compatible con lo que suele hacer el usuario. Si no lo es, puede emitir una alerta al banco para que éste decida si me hace una llamada para confirmar si esa operación la estoy realmente haciendo yo. Puede incluso llegar a cancelar la tarjeta si estima que el riesgo es muy alto. Es algo que va funcionando de manera invisible y la gente de a pie no lo aprecia. Si el banco te llama de vez en cuando y te pregunta para confirmar si has hecho unas determinadas acciones, es porque nuestro sistema lo ha recomendado al observar estos pasos por si se hubiera producido un fraude. Este sistema está controlando en España el 100% de las operaciones de tarjeta de crédito.

¿Todas las operaciones con tarjetas de crédito están supervisadas por Lynx?

Sí.

No hay que coger miedo a las redes sociales ni a Internet, pero a veces la gente no es verdaderamente consciente de las cosas y de la información que publican. Una vez que compartes algo, dejas de tener control sobre ello

En Big Data, ¿hay proyectos más sencillos de hacer que otros?

Sí, por supuesto. Nosotros trabajamos en el análisis de datos, pero dentro de este campo hay varios niveles de complejidad. Además, antes hay que hacer varios procesos.

En primer lugar, necesitas una infraestructura de máquinas de hardware. Ahora se apuesta mucho por el cloud computing para poder aprovechar toda la flexibilidad y la disponibilidad que te dan estos proveedores. Una vez que tienes las máquinas, hay una serie de tecnologías software que te permiten almacenar grandes volúmenes de datos y trabajar con ellos. Son aplicaciones muy distintas a las que solíamos tener tradicionalmente. Por ejemplo, antes se utilizaban muchos las bases de datos SQL, que era el estándar para almacenar información. Ahora se está moviendo mucho hacia las bases de datos NoSQL. No es que sean mejores ni peores, pero que en determinados entornos ofrecen algunas ventajas.

Una vez que la infraestructura de hardware y software está configurada, se pasaría a la parte de análisis. Dentro del análisis hay varios niveles de complejidad. Lo más simple, entre comillas, y dependiendo también de la magnitud y complejidad de los datos, suele ser la analítica descriptiva, donde se toman grandes volúmenes de información y se resumen en métricas generales, KPIs, visualizaciones que te permitan entender qué es lo que reflejan esos datos y que fenómenos hay subyacentes y que pueden no ser evidentes pero que se pueden extraer a través de estos análisis. Eso sería lo más básico. La mayoría de los proyectos de Big Data en España se mueven en este nivel.

El siguiente es el predictivo. Aquí se intenta construir algoritmos estadísticos que puedan predecir datos que no tienes en ese momento. Por ejemplo, en el caso de la aplicación de fraude, Lynx lo que hace es predecir y adelantarse a la información en el momento en el que se está produciendo la transacción, e intenta adivinar si esa transacción es legítima o no. Es aquí donde entran todos estos algoritmos y técnicas de predicción.

El nivel más complejo -que es algo en lo que estamos empezando a trabajar desde hace algunos años- es el nivel prescriptivo. Este nivel consiste en que los algoritmos te puedan dar recomendaciones sobre qué deberías hacer. Hemos trabajado también con el sector banca en intentar y hacer recomendaciones sobre cuál es el momento ideal para cargar los cajeros de efectivo, para pedir furgones blindados para transportar ese dinero efectivo para garantizar que siempre están disponibles cajeros y para no tener dinero en exceso… Es un nivel en el que el resultado del análisis de datos no es un resumen de los mismos, sino una recomendación para realizar una acción directa.

En su opinión, ¿cuál es el nivel de desarrollo existe en España en cuanto al trabajo con Big Data?

Hay que diferenciar entre lo que es el nivel universitario o más científico y técnico de lo que es el nivel más empresarial. Dentro de lo que son las empresas españolas existe un entramado de start-ups que van apareciendo y desapareciendo pero que, en general, está muy interesado en aprovechar las últimas tecnologías. Pero para la gran mayoría de grandes y medianas empresas se mueven más en un negocio más tradicional. Sí que es verdad que, de unos años a esta parte, cada vez están más interesadas en el Big Data, son más conscientes de eso y tienen interés. Todavía están empezando, diría que van todavía poco a poco.

¿Big Data es solo para grandes empresas, tipo bancos y operadoras? ¿O también para pymes?

Yo creo que es como cualquier otra tecnología. Me gusta compararlo a cuando empezó a aparecer la informática: las primeras empresas que adoptan son normalmente las que pueden sacar más beneficio de ello. De España no tengo estadísticas a nivel internacional, las empresas que más lo han adoptado son las que están muy pegadas al desarrollo de software y son más activas a este mundo digital y de los datos. Luego le siguen empresas de consultoría informática, banca y el mundo del marketing para aplicación de campañas, análisis de comportamiento de clientes, etcétera. Poco a poco se van añadiendo el resto de sectores, cada uno con sus capacidades. Pero es algo que está permeando a todo el empresariado.

Ha habido muchas críticas a Big Data tras salir elegido Trump en las elecciones de Estados Unidos (quizá en parte también porque de Obama siempre se dijo que había hecho un buen uso del Big Data). ¿Cuál es su opinión al respecto?

Incidirá en lo que comentaba antes: Big Data es una herramienta más. En realidad, es un término más de marketing, una «buzzword» que se ha montado. Detrás hay muchas técnicas que van desde lo que es la estadística clásica para hacer encuestas de estimación de votos (algo que se lleva haciendo desde hace muchísimos años y que, en función de cómo se haga, los resultados son precisos o no) a otras tecnologías más complejas.

las primeras empresas que adoptan son normalmente las que pueden sacar más beneficio de ello, como las pegadas al desarrollo de software

Cuando se hacen este tipo de estudios electorales también hay un cierto sesgo e intencionalidad.

Es algo que hay que tener en cuenta. Cuando se habla de que las selecciones americanas con Obama que había utilizado técnicas de Big Data y fueron un éxito y ahora las de Hilary no lo ha sido tanto, hay que señalar que Big Data es una herramienta más. En las elecciones hay unas técnicas que permiten medir pero, evidentemente, tienes que hacer algo con esos resultados. Hay que tener en cuenta, además, todo lo que influye en la elección: publicidad, redes sociales… Son muchos factores los que influyen. No diría que es un fracaso porque no haya funcionado. Puede que no le hayan sacado buen partido porque haya fallado en este caso particular o porque no se ha utilizado bien.

El análisis de datos se está utilizando en muchos sectores y tienen soluciones que son realistas y que funcionan todos los días, como la solución que tenemos de fraude.

¿Puede ser el gran hándicap del Big Data los datos no estructurados?

Cuando hablamos de datos no estructurados, nos referimos a datos no tabulados como si fuera una tabla Excel. Por ejemplo, si haces una encuesta en la calle, respuestas tipo sí o no son datos estructurados. Pero si recoges opinión libre, los comentarios literales de cada persona son datos no estructurados. Analizarlo tiene un nivel de complejidad superior porque requiere unas técnicas algorítmicas capaces de procesar ese lenguaje natural. Esas técnicas existen y cada año van mejorando, pero todavía no estamos al nivel de un ser humano. No va a ser igual de certero el análisis de una persona experta en el tema que pueda leerse esos texto y realizar un análisis y una conclusión que un algoritmo que haga lo mismo. La ventaja que tienen estos algoritmos es que son muy rápidos y pueden analizar miles de millones de palabras muy rápidamente y darte unas conclusiones sobre ellos. Es un intercambio entre ser muy preciso (algo que tiene que hacer una persona) o ser muy rápido (que es lo que hace una máquina).

Otros datos no estructurados son fotografías, imágenes, vídeos, lenguaje en voz en vez de texto… Desde la aparición de las redes sociales es un tema que se está desarrollando mucho. Se puede analizar también, con sus dificultades, pero poco a poco se puede sacar algo.

Otro factor importante es la representatividad de lo que estás midiendo. Ahora se habla mucho de que con las redes sociales puedes medir la opinión de la población, si está en línea con un candidato u otro. Pero hay que tener en cuenta que los usuarios más presentes en redes sociales suelen ser gente joven. Hay ciertos sectores de la población que no aparecen reflejados y es algo que hay que tener en cuenta cuando realizas un análisis de cara a un posible vencedor de las elecciones o si haces una campaña de marketing.

Quizá es cuestión de tiempo: el avance de la tecnología y que todos los segmentos de edad, según vayan creciendo, acaben estando representados…

Eso seguro. La tecnología y el análisis de estos datos avanzará mucho más de lo que está ahora.

Hay varios niveles de complejidad en el análisis de datos. El más sencillo es en el que se mueven la mayoría de los proyectos en España. El más complicado es en el que el algoritmo te recomienda qué acciones debes tomar

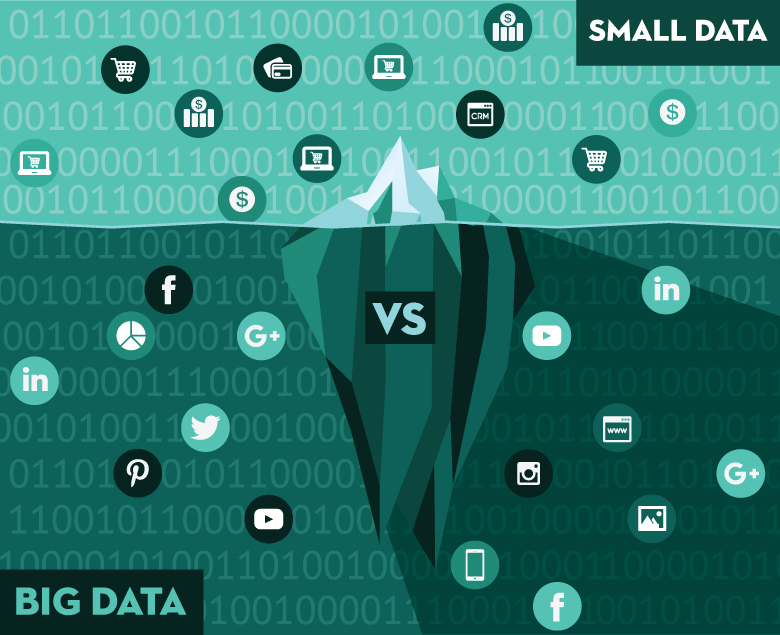

Se habla mucho de Small Data últimamente y algunos creen que es más importante que el Big Data. ¿Cuál es su visión? ¿Cómo diferencia uno de otro?

Hace poco me hicieron una pregunta parecida, si prefería Big Data, Small Data o Smart Data. La verdad es que no sé muy bien qué decir, porque son definiciones que nunca había oído. Son otra especie de buzzwords que van saliendo de vez en cuando. Lo que puedo decir es que si buscas Big Data en Wikipedia, lo que dice va en la línea de las tecnologías de conocimiento: serie tecnologías que sirven para tratar datos que no se puede manejar con las tecnologías tradicionales. Esta definición también es un poco difusa, porque no te da una definición fija de a partir de tantos gigas a teras es Big Data y antes no. Depende mucho de lo que vayas a hacer con esos datos.

Lo que está claro es que al final quieres utilizar datos y hacer un análisis sobre ellos para responder preguntas, para ver qué está pasando o qué puede pasar en el futuro, o para que el algoritmo te dé una revelación sobre lo que deberías hacer. Eso, a veces, necesitará muchos datos si el problema es muy complejo o quieres representar las opiniones y la forma de actuar de mucha gente. Pero hay veces que con pocos datos también puedes hacer una cosa bastante sensata. Nosotros trabajamos en algunos proyectos que son muy grandes (como el de detección de fraude, donde trabajamos con millones y millones de operaciones bancarias y el algoritmo tiene que interpretarlas para ver si hay fraude o no), pero en otros campos utilizamos modelos algo más predictivos y más avanzados. Las técnicas que utilizamos de análisis de datos y almacenamiento son bastantes estándar porque los datos no son tan grandes. Lo importante, y en lo que hay que fijarse, más que en el tamaño de los datos es en si representan la información suficiente como para que te sirvan para tomar una decisión.

Es decir, en el valor del dato.

Sí. Es una de las V de las que se habla del Big Data. Cada vez se van añadiendo más, pero una de ellas es el valor que se centra en eso. Puedes tener muchísimos datos, pero si no hay nada útil no vale para nada.

Hablar de Big Data también supone hablar de ley de protección de datos especialmente en España o en Europa. ¿Cómo es el trabajo que tenéis que realizar con este tipo de regulación? ¿Es distinto cuando tenéis que realizar un desarrollo para España que para Estados Unidos, donde suelen ser más permisivos?

Somo un instituto en España y, por tanto, se nos aplica la legislación española, una de las más exigentes no solamente en Europa sino en todo el mundo en cuanto a protección de datos. Hay toda una serie de medidas de seguridad que tenemos que cumplir. Por ejemplo, nosotros intentamos trabajar con datos que se llaman anonimizados. Intentamos que la información que nos envíen los clientes para los que estamos haciendo estas soluciones no tengan ningún campo que nos permita identificar a qué persona corresponde. No es solo nombre y apellido, sino también cosas como el DNI, dirección, correo electrónico, dirección IP de sus máquinas (Europa que ha dicho hace poco que también era un dato personal). Intentamos descaracterizarlo. En casos en los que no se puede porque hay que tomar decisiones sobre personas, tenemos una serie de procedimientos que exige la LOPD. Los datos que te permiten hacer el enlace entre esos datos con la persona concreta tienen que estar en servidores seguros, tienen que tener un registro de quién accede a esa información, que no puede salir de aquí… Tenemos políticas de seguridad para garantizar que eso es así. Hay bastantes ángulos que tienes que tener en cuenta. La LOPD establece que no se pueden recoger datos indiscriminadamente para aplicarlos con cualquier propósito. Cuando un banco o cualquier tipo de entidad recoge datos de sus clientes tiene que informarles con qué propósito están recogiendo sus datos. El cliente tiene que dar su aprobación. Nosotros no somos los que recogemos los datos, si no que hacemos el trabajo de análisis. La entidad con la que colaboramos nos da su permiso para poder hacerse el tratamiento de datos solamente durante el transcurso del proyecto. Una vez que el proyecto termina, se eliminan todos los datos que tenemos aquí y no podemos recuperarlo de ninguna manera. La ley te pone una serie de medidas que tienes que cumplir para garantizar que no va haber fuga de datos, que no se puede identificar a personas particulares etcétera. Aquí hay un debate sobre si en España somos demasiado estrictos o no en Estados Unidos como comentabas son más livianos en estas restricciones.

Intentamos distinguirnos de otras empresas de Big Data por hacer este análisis más avanzado, por hacer técnicas de análisis predictivo y prescriptivo. Estamos muy en contacto con el mundo universitario para ver qué nuevas investigaciones se están haciendo

Hay dos corrientes de opinión en este sentido: los que abogan por seguir siendo estrictos con la protección de datos y los que piden ser más permisivos para no perder el tren y que las empresas europeas estén en igualdad de condiciones de desarrollar sus negocios que las de Estados Unidos. ¿Cuál es su opinión, como experto en Big Data?

Cuando se proponen estas leyes aún no está claro qué efecto puede tener sobre la gente. Van saliendo casos de fugas de información. Hace unos años hubo un caso de Inglaterra donde una banda de ladrones se dedicaba a comprobar cuándo la gente hacía check-in en Foursquare para ver si estaba lejos de donde solían vivir para aprovechar e ir a robar a sus casas. La ley de protección de datos tampoco te puede proteger, porque tú por propia voluntad compartes esa información. Pero creo que estas cosas están llevando a que la gente tenga un poco más de conocimiento, a tener una idea de que sus datos los puede ver cualquiera. Cosas como poner dónde vives o dónde estás poco a poco la gente va teniendo un poco más de conciencia sobre los riesgos. No todo el mundo, pero poco a poco va permeando un poco.

Por un lado, la ley tiene que hacer algo, porque no se puede dar libertad total. Sería muy peligroso y para los negocios posiblemente tendría un elemento de retroceso porque la gente dejaría de compartir información al tener más miedo. Tienes que tener una ley que de soporte. Pero, por otra parte, lo que pasa con la legislación española particular es que en algunos puntos es bastante ambigua y muchas empresas lo que intentan es ponerse en el lado más seguro. Como no está claro si se puede o no se puede hacer, por si acaso se ponen en la posición más conservadora.

Estas leyes deberían intentar que fueran más específicas. Vamos a ver si con la renovación de la ley europea en 2017 esto se estandariza un poco más. Puedo entender que sea difícil regularlo porque es algo nuevo, pero que hay que intentar dejarlo definirlo para que las empresas tengan muy claro qué es lo que pueden hacer con los datos y lo que no, para intentar en la medida de lo posible los peligros.

Vamos al otro punto de vista. Como experto en Big Data, ¿somos conscientes la gente de a pie de la importancia de los datos, de cómo los regalamos y del valor que tienen? También aquí tenemos dos extremos de usuarios: el que no quiere compartir nada y no tiene ningún perfil en red social al que comparte todo porque asegura que no tiene nada que ocultar…

Efectivamente, se ven los dos perfiles y bastante frecuentemente. Creo que hay que ser precavido porque, en el fondo, tus datos son una parte tuya.

Normalmente se publican cosas en Twitter para que lo vean tus conocidos, familiares o amigos y no para que lo vea todo el mundo (salvo que se esté buscando en convertirse en un Influencer). Mucha gente tampoco es consciente del impacto que tiene esto y es difícil verlo. Cuando empezamos a trabajar capturando datos de redes sociales estábamos bastante sorprendidos de lo que aparece y de que la gente no parece ser consciente de lo que está diciendo. Te encuentras muchos mensajes en Twitter de gente que, los lunes, dice que está muy cansada y que no le apetece trabajar. No se hace para que todo el mundo lo vea porque no es nada relevante y, aunque hay los dos extremos que comentabas, la gente en general no es consciente de hasta dónde pueden llegar los mensajes o las fotos que publican. Creo que sí que es importante que se haga una cierta educación. Sobre todo porque, una vez que pones algo público en Internet, has perdido el control sobre ello y puede estar en cualquier sitio. No es algo a lo que haya que coger miedo, pero es algo que hay que usar con responsabilidad. De la misma forma que la gente no se comporta igual en casa que en la calle, en Internet debería ser algo parecido.

En Nobbot | Big data y smart data: cantidad frente a calidad